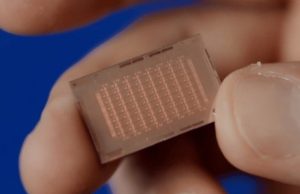

採台積電 5 奈米製程,Meta 下一代自研 AI 晶片性能提升 3 倍

作者 陳 冠榮 發布日期 2024 年 04 月 11 日

Meta 去年公開首款自研晶片 MTIA(Meta Training and Inference Accelerator)成果,第一代 MTIA(MTIA v1)即採台積電 7 奈米製程,下一代 MTIA 同樣委由台積電生產。

在英特爾、Google 發表最新 AI 晶片之後,Meta 10 日也公開自研晶片開發成果。MTIA v1 後繼產品官方稱為下一代 MTIA(Next Gen MTIA),它執行的模型用於處理與 AI 推薦系統相關的工作。與台積電 7 奈米製程建構的 MTIA v1 相比,下一代 MTIA 採用 5 奈米製程。

下一代 MTIA 配備更多處理核心,擁有更多 on-chip memory(256MB 對比 MTIA v1 128MB)和 off-chip LPDDR5(128GB 對比 MTIA v1 64GB),並以更高的平均時脈速度運行,從 800MHz 上升到 1.35GHz,同時功耗增加(90W 對比 MTIA v1 25W)。

Meta 指出,下一代 MTIA 目前已投入 16 個資料中心區域使用。Meta 評估的四個關鍵模型中,下一代 MTIA 性能比 MTIA v1 提升 3 倍,「由於我們控制整個堆疊,所以與商用 GPU 相比,可以達成更高的運算效率」,Meta 部落格文章寫道。

Meta 也透露,目前還沒有使用下一代 MTIA 訓練生成式 AI,儘管該公司聲稱有多項專案正在進行。此外,Meta 承認下一代 MTIA 不會取代目前用於訓練模型的 GPU,而是補充運算資源。

英特爾最新發表 Gaudi 3,聲稱能源效率比 NVIDIA H100 晶片高 40%,推論速度快 50%。Google 正向 Google Cloud 客戶推出用於訓練 AI 模型的 TPU v5p,並發表首款為資料中心設計的 Arm 架構 Axion CPU。亞馬遜擁有多款自研 AI 晶片,微軟去年也已 AI 晶片 Azure Maia 100 和雲端運算處理器 Azure Cobalt 100 參戰。

Meta 近年不遺餘力加強 AI 技術開發,自行研發客製化晶片以滿足運算需求。該公司一直是 NVIDIA H100 GPU 的大客戶,今年底前 Meta 運算基礎設施預計採購達到 35 萬顆 H100。同時 MTIA 系列晶片開發也將加速進行,希望在 AI 軍備競賽趕上競爭對手。